最近项目上要在mtk6589机器上增加录像的水印功能,那个纠结呀…… 一大通 度娘、google啊……

最终整个变通的方案:做好10几个bmp(8位深度黑底白字)贴图,把文件使用ue去除掉bmp文件头(字节435h之后为具体文件内容)之后再使用工具FILE2C转成C数组,然后贴在在camera视频数据中。

留个记录以便于有朋友有类似需求,也方便以后自己查看

步骤:

1、 制作bmp位图数据文件:digital_data.h (内容太大,为不影响阅读具体内容贴在本文最后)

const int digital_width =24; const int digital_height =38;

const int gap_width = 0;

const unsigned char colon[912] = { 0x00,0x00,…} 黑底白字位图,数据要么为0x00,要么为0xff

const unsigned char* DigitalArray[] = {

&digital_0[0],

&digital_1[0],

&digital_2[0],

&digital_3[0],

&digital_4[0],

&digital_5[0],

&digital_6[0],

&digital_7[0],

&digital_8[0],

&digital_9[0],

&dash[0],

&colon[0]

};

2、把位图数据覆盖到视频数据的相应位置

CameraSource.cpp

void CameraSource::dataCallbackTimestamp(int64_t timestampUs,

int32_t msgType, const sp<IMemory> &data) {

…

CHECK(data != NULL && data->size() > 0); 本行及以上为原始代码, 中间为新增代码

mFramesReceived.push_back(data);本行及以下代码为原始代码

…

}

3,、改方式仅为临时方式,以后有待改进,最好能在代码中把text文本做成bitmap格式然后贴到视频数据上,但目前一直没找到方法实现……

移植到L平台上的录像截图:

获取系统支持的Camera情景模式

在底层vendor/mediatek/proprietary/custom/mt6735/hal/D1/sendepfeature/ov8858_mipi_raw/config.ftbl.ov8858_mipi_raw.h 这个文件定义的我们的相机支持哪些情景模式

这个文件定义的我们的相机支持的哪些情景模式,SCENE_MODE_HDR,, HDR模式, SCENE_MODE_NIGHT夜景模式……..

有了这个后, android framework会根据这些做相应的处理, 然后传入到上层, 上层java就可以判断我们是否能支持该模式,

在hal层, CameraHardwareInterface.h中

status_t initialize(hw_module_t *module)

{

……

camera_module_t *cameraModule = reinterpret_cast<camera_module_t *="">(module);

camera_info info;

status_t res = cameraModule->get_camera_info(atoi(mName.string()), &info);

……

}</camera_module_t>

这里进行初始化Camera的相关信息, 我们所需要的情景模式保存在结构体 camera_info中。

在CameraService.cpp中getCameraCharacteristics()方法中获取CameraInfo信息

status_t CameraService::getCameraCharacteristics(int cameraId, CameraMetadata* cameraInfo) {

if (!cameraInfo) {

ALOGE("%s: cameraInfo is NULL", __FUNCTION__);

return BAD_VALUE;

}

if (!mModule) {

ALOGE("%s: camera hardware module doesn't exist", __FUNCTION__);

return -ENODEV;

}

if (cameraId < 0 || cameraId >= mNumberOfCameras) {

ALOGE("%s: Invalid camera id: %d", __FUNCTION__, cameraId);

return BAD_VALUE;

}

int facing;

status_t ret = OK;

if (mModule->common.module_api_version < CAMERA_MODULE_API_VERSION_2_0 ||

getDeviceVersion(cameraId, &facing) <= CAMERA_DEVICE_API_VERSION_2_1 ) {

/**

* Backwards compatibility mode for old HALs:

* – Convert CameraInfo into static CameraMetadata properties.

* – Retrieve cached CameraParameters for this camera. If none exist,

* attempt to open CameraClient and retrieve the CameraParameters.

* – Convert cached CameraParameters into static CameraMetadata

* properties.

*/

ALOGI("%s: Switching to HAL1 shim implementation…", __FUNCTION__);

if ((ret = generateShimMetadata(cameraId, cameraInfo)) != OK) {

return ret;

}

} else {

/**

* Normal HAL 2.1+ codepath.

*/

struct camera_info info;

ret = filterGetInfoErrorCode(mModule->get_camera_info(cameraId, &info));

*cameraInfo = info.static_camera_characteristics;

}

return ret;

}

下面列出参考文件:

以下内容转自:http://blog.csdn.net/tankai19880619/article/details/16848135

camera 录像过程:

最近调试系统Camera,遇到如下问题:在录像过程中,拔掉Camera;会出现应用程序卡死现象。

先说说之前的设计架构:

当用户拔掉Camera时,会给应用程序发送广播;当应用程序收到广播后调用Activity类的finish方法(系统会自动调用onPause方法),而我们的onPause方法做了停止录制和关闭Camera的动作。

问题出在:

当调用系统MediaRecorder的stop方法停止录制时,应用程序因为阻塞而卡死。

下面就着重分析下系统Camera和MediaRecorder(libstagefright中MPEG4Writer以及CameraSource的关系)。

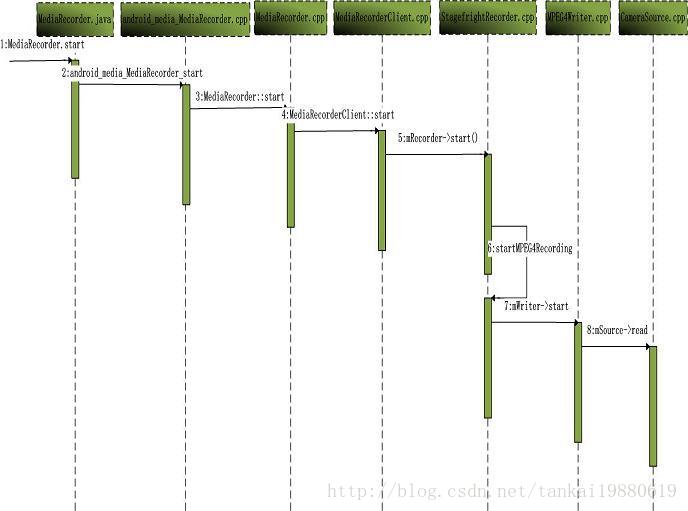

首先,通过图示、看看Android系统Camera录像时的调用时序:

1.录像命令时序

wps office 官方下载的入口是什么 wps的官网最新的下载方法在哪里

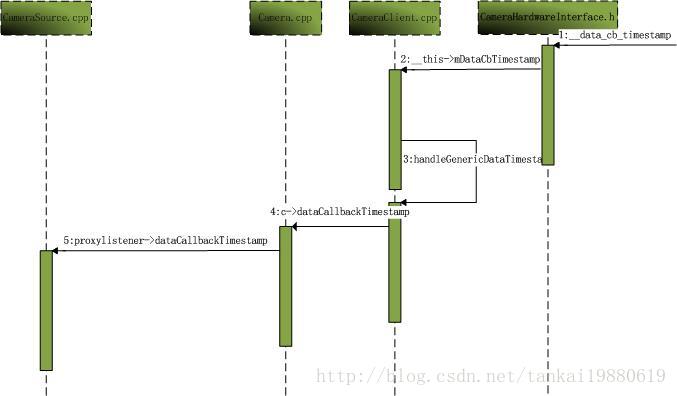

2.录像数据回调时序

一、应用部分

1.主Activity启动

packages/apps/Camera/src/com/android/camera/CameraActivity.java

2.录像Activity初始化

packages/apps/Camera/src/com/android/camera/VideoModule.java

3.开始录制和停止录制

二、框架部分

1.MediaRecorder的API部分

frameworks/base/media/java/android/media/MediaRecorder.java

2.Native部分

frameworks/base/media/jni/android_media_MediaRecorder.cpp

3.C++部分

frameworks/av/media/libmedia/MediaRecorder.cpp

4.服务端(Android的Binder)

frameworks/av/media/libmediaplayerservice/MediaRecorderClient.cpp

Android4.2多媒体使用Stagefright架构

frameworks/av/media/libmediaplayerservice/StagefrightRecorder.cpp

MPEG4编码器部分

frameworks/av/media/libstagefright/MPEG4Writer.cpp

当有数据来时CameraSource的dataCallbackTimestamp函数会被调用,如此、完成视频录制。

三、分析问题

我们的问题就出在直接拔掉Camera时;应用程序调用mMediaRecorder.stop()超时卡死;经分析是上述框架部分“Camera拔出时录制的主线程不能退出、导致接口阻塞”。后调试发现:mDone变量并不能在两个线程间传参数;后打入之前一个patcher(see bug 4724339),修改了主线程中的mSource->read、并在相应的while循环中做判断,问题解决。

frameworks/av/media/libstagefright/CameraSource.cpp

四、补充,分析MPEG4中Audio流程;接分析二中的实现

1.Audio录音

frameworks/av/media/libmediaplayerservice/StagefrightRecorder.cpp

frameworks/av/media/libstagefright/AudioSource.cpp

至此,MediaRecorder与AudioFlinger建立联系。

2.Audio放音

MediaPlayer播放音频服务端(后边有时间在具体分析应用程序/客户端流程):

frameworks/av/media/libmediaplayerservice/MediaPlayerService.cpp

以下转自: http://www.2cto.com/kf/201303/196681.html

Camera 调用流程:

1. 首先是调用framework层的Camera.java(frameworksbasecorejavaandroidhardware)的takePicture方法

2. 接着会调用到JNI层的android_hardware_Camera.cpp(frameworksbasecorejni)的android_hardware_Camera_takePicture方法,其中会通过get_native_camera获取一个Camera对象。

3. 上述Camera对象的定义在Camera.h(frameworksavincludecamera),camera.h同时定义了CameraInfo。Camera对象继承自publicBnCameraClient,DeathRecipient。Camera对象的真正实现是在Camera.cpp(frameworksavcamera) 。BnCameraClient是作为CameraService回调而存在的。Camera对象内含有一个mCameraService变量用于保存CameraService引用。

class Camera : public BnCameraClient,public IBinder::DeathRecipient

constsp<ICameraService>& Camera::getCameraService()

{

Mutex::Autolock _l(mLock);

if (mCameraService.get() == 0) {

sp<IServiceManager> sm = defaultServiceManager();

sp<IBinder> binder;

do {

binder =sm->getService(String16("media.camera"));

if (binder != 0)

break;

ALOGW("CameraService notpublished, waiting…");

usleep(500000); // 0.5 s

} while(true);

if (mDeathNotifier == NULL) {

mDeathNotifier = newDeathNotifier();

}

binder->linkToDeath(mDeathNotifier);

mCameraService =interface_cast<ICameraService>(binder);

}

4. 在ICameraClient.h和ICameraService.h文件中,ICameraClient和ICameraService都继承自IInterface,也就是Binder通信的基础,此外ICamera.h也继承自IInterface

class ICameraClient:public IInterface

class ICameraService :public IInterface

class ICamera: publicIInterface

然后发现BnCameraClient继承自BnInterface<ICameraClient>,作为ICameraClient的服务器端存在:

class BnCameraClient: publicBnInterface<ICameraClient>

BnCameraService继承自BnInterface<ICameraService>,作为ICameraService的服务器端存在:

class BnCameraService: publicBnInterface<ICameraService>

BnCamera继承自BnInterface<ICamera>,作为ICamera的服务器端存在:

class BnCamera: public BnInterface<ICamera>

对应的上述三个分别存在一个作为Binder客户端的类存在,为Bp***:

class BpCameraClient:public BpInterface<ICameraClient>

class BpCameraService:public BpInterface<ICameraService>

class BpCamera: publicBpInterface<ICamera>

上述三个的实现分别在ICameraClient.cpp、ICameraService.cpp、ICamera.cpp,在这三支文件中分别实现了三组Binder的Server端和Client端,Camera常用的方法都在ICamera中实现。

5. Camera.cpp文件connect方法在JNI层去setupCamera的时候会调用,JNI层是在上层opencamera的时候被调用的,在camera.cpp的connect方法中获取一个ICamera对象来完成对Camera的真正操作。

sp<Camera>Camera::connect(int cameraId)

{

ALOGV("connect");

sp<Camera> c = new Camera();

const sp<ICameraService>& cs =getCameraService();

if (cs != 0) {

c->mCamera = cs->connect(c, cameraId);

}

if (c->mCamera != 0) {

c->mCamera->asBinder()->linkToDeath(c);

c->mStatus = NO_ERROR;

} else {

c.clear();

}

return c;

}

6. 在CameraService.h文件中可以看到CameraService定义内部类Client,CameraClient继承此类,在CameraService中持有对mClient对象的一个数组,这个数组也是Camera.cpp客户端调用connect方法后需要返回的Binder引用对象

class Client : public BnCamera

class CameraClient : public CameraService::Client

wp<Client> mClient[MAX_CAMERAS];

switch(deviceVersion) {

case CAMERA_DEVICE_API_VERSION_1_0:

client = new CameraClient(this,cameraClient, cameraId,

info.facing, callingPid, getpid());

break;

casewps office免费版下载入口是什么 CAMERA_DEVICE_API_VERSION_2_0:

client = new Camera2Client(this,cameraClient, cameraId,

info.facing, callingPid,getpid());

并且Google好像有开发新的API2.0,在此处通过判断不同的version实例化不同的CameraClient的Binder引用对象回去,目前Camera2文件夹有Burst等实现

7. 在CameraService层的CameraClient对象的定义中,持有CameraHardwareInterface对象的引用mHardware.在CameraClient的initilize方法中会创建此对象,在对象的构造方法中传入需要打开的Camera的ID。

sp<CameraHardwareInterface> mHardware;

status_t CameraClient::initialize(camera_module_t *module) {

int callingPid = getCallingPid();

LOG1("CameraClient::initialize E (pid%d, id %d)", callingPid, mCameraId);

char camera_device_name[10];

status_t res;

snprintf(camera_device_name, sizeof(camera_device_name),"%d", mCameraId);

mHardware = new CameraHardwareInterface(camera_device_name);

res = mHardware->initialize(&module->common);

if (res != OK) {

ALOGE("%s: Camera %d: unable toinitialize device: %s (%d)",

__FUNCTION__, mCameraId,strerror(-res), res);

mHardware.clear();

return NO_INIT;

}

mHardware->setCallbacks(notifyCallback,

dataCallback,

dataCallbackTimestamp,

(void*)mCameraId);

//Enable zoom, error, focus, and metadata messages by default

enableMsgType(CAMERA_MSG_ERROR | CAMERA_MSG_ZOOM | CAMERA_MSG_FOCUS |

CAMERA_MSG_PREVIEW_METADATA | CAMERA_MSG_FOCUS_MOVE);

//!++

#ifdef MTK_CAMERA_BSP_SUPPORT

// Enable MTK-extended messages by default

enableMsgType(MTK_CAMERA_MSG_EXT_NOTIFY |MTK_CAMERA_MSG_EXT_DATA);

#endif

//!–

LOG1("CameraClient::initialize X (pid%d, id %d)", callingPid, mCameraId);

return OK;

}

8. 在CameraService的onFirstRef方法中,会加载CameraHal Module

void CameraService:: onFirstRef()

{

BnCameraService::onFirstRef();

if (hw_get_module(CAMERA_HARDWARE_MODULE_ID,

(const hw_module_t**)&mModule) < 0) {

ALOGE("Could not load camera HALmodule");

mNumberOfCameras = 0;

}

else {

mNumberOfCameras =mModule->get_number_of_cameras();

if (mNumberOfCameras > MAX_CAMERAS){

ALOGE("Number of cameras(%d)> MAX_CAMERAS(%d).",

mNumberOfCameras, MAX_CAMERAS);

mNumberOfCameras = MAX_CAMERAS;

}

for (int i = 0; i <mNumberOfCameras; i++) {

setCameraFree(i);

}

}

}

hw_get_module方法的实现在hardware/libhardware/Hardware.c文件中实现

int hw_get_module(constchar *id, const struct hw_module_t **module)

{

return hw_get_module_by_class(id, NULL,module);

}

Camera_module_t的结构体定义在camera_common.h文件中

typedef structcamera_module {

hw_module_t common;

int (*get_number_of_cameras)(void);

int (*get_camera_info)(int camera_id,struct camera_info *info);

} camera_module_t;

Hw_module_t的定义在hardware.h文件中,hw_module_t持有对hw_module_methods_t引用,其中有定义一个open指针

typedef structhw_module_methods_t {

/** Open a specific device */

int (*open)(const struct hw_module_t*module, const char* id,

struct hw_device_t** device);

} hw_module_methods_t;

而加载CamDevice的操作是在CameraHardwareInterface的initialize方法中调用open

status_t initialize(hw_module_t *module)

{

ALOGI("Opening camera %s", mName.string());

int rc = module->methods->open(module, mName.string(),

(hw_device_t **)&mDevice);

if (rc != OK) {

ALOGE("Could not open camera %s: %d", mName.string(), rc);

return rc;

}

initHalPreviewWindow();

return rc;

}

CameraClient::initialize->

mHardware = new CameraHardwareInterface(camera_device_name);

res = mHardware->initialize(&module->common);

以下转自:http://www.open-open.com/lib/view/open1328063735233.html

android camera介绍

总体介绍 Android Camera 框架从整体上看是一个 client/service 的架构,有两个进程:一个是 client 进 程,可以看成是 AP 端,主要包括 JAVA 代码与一些 native c/c++代码;另一个是 service 进 程,属于服务端,是 native c/c++代码,主要负责和 linux kernel 中的 camera driver 交互,搜 集 linux kernel 中 camera driver 传上来的数据,并交给显示系统(surface)显示。client 进程与 service 进程通过 Binder 机制通信, client 端通过调用 service 端的接口实现各个具体的功能。 需要注意的是真正的 preview 数据不会通过 Binder IPC 机制从 service 端复制到 client 端, 但 会通过回调函数与消息的机制将 preview 数据 buffer 的地址传到 client 端, 最终可在 JAVA AP 中操作处理这个 preview 数据。 client 端 从 JAVA AP 的角度看 camera ap 就是调用 FrameWork 层的 android.hardware.camera 类来实现 具体的功能。JAVA Ap 最终被打包成 APK。 FrameWork 层主要提供了 android.hardware.camera 类给应用层使用,这个类也是 JAVA 代码 实 现 。 Android.hardware.camera 类 通 过 JNI 调 用 native 代 码 实 现 具 体 的 功 能 。 Android.hardware.camera 类中提供了如下的一个参数类给应用层使用: public class Parameters { // Parameter keys to communicate with the camera driver。 private static final String KEY_PREVIEW_SIZE = "preview-size"; private static final String KEY_PREVIEW_FORMAT = "preview-format"; …… } 参数会以字典(map)的方式组织存储起来,关键字就是 Parameters 类中的这些静态字符 串。这些参数最终会以形如“preview-size=640X480;preview-format=yuv422sp;….”格式的 字符串传到 service 端。 源代码位于:framework/base/core/java/android/hardware/camera.java

提供的接口示例:

获得一个 android.hardware.camera 类的实例

public static Camera open() {

return new Camera();

}

接口直接调用 native 代码(android_hardware_camera.cpp 中的代码)

public native final void startPreview();

public native final void stopPreview();

android.hardware.camera 类的 JNI 调用实现在 android_hardware_camera.cpp 文件中,源代码

位置: framework/base/core/jni/android_hardware_camera.cpp

(framework/base/core/jni/文件夹下的文件都被编译进 libandroid_runtime.so 公共库中 )

android_hardware_camera.cpp 文件中的 JNI 调用实现函数都如下图:

android_hardware_camera.cpp 文件中的 register_android_hardware_Camera(JNIEnv *env)函数

会将上面的 native 函数注册到虚拟机中,以供 FrameWork 层的 JAVA 代码调用。这些 native

函数通过调用 libcamera_client.so 中的 Camera 类实现具体的功能。

核心的 libcamera_client.so 动态库源代码位于: frameworks/base/libs/camera/, 实现了如下几

个类:

Camera—->Camera.cpp/Camera.h

CameraParameters—>CameraParameters.cpp/CameraParameters.h

Icamera—>ICamera.cpp/ICamera.h

IcameraClient—>ICameraClient.cpp/ICameraClient.h

IcameraService—>ICameraService.cpp/ICameraService.h

Icamera、IcameraClient、IcameraService 三个类是按照 Binder IPC 通信要求的框架实现的,用

来与 service 端通信。

类 CameraParameters 接收 FrameWork 层的 android.hardware.camera::Parameters 类为参数,

解析与格式化所有的参数设置。

Camera 是一个很重要的类, 它与 CameraService 端通过 Binder IPC 机制交互来实现具体功能。

Camera 继承自 BnCameraClient,并最终继承自 ICameraClient。

Camera 类通过:

sp sm = defaultServiceManager();

sp binder = sm->getService(String16("media.camera"));

sp mCameraService = interface_cast (binder);

得到名字为“media.camera”的 CameraService。通过调用 CameraService 的接口 connect()返

回得到 sp mCamera,并在 CameraService 端 new 一个 CameraService::Client 类官网wps office免费版的下载网址是什么(wps最新打不开)

mClient。mClient 继承自 BnCamera,并最终继承自 ICamera。

之 后 Camera 类 通 过 这 个 sp mCamera 对 象 调 用 函 数 就 像 直 接 调 用

CameraService::Client 类 mClient 的函数。CameraService::Client 类实现具体的功能。

service 端

实现在动态库 libcameraservice.so 中, 源代码位于: frameworks/base/camera/libcameraservice Libcameraservice.so 中主要有下面两个类:

Libcameraservice.so::CameraService 类 , 继 承 自 BnCameraService , 并 最 终 继 承 自

ICameraService

Libcameraservice.so::CameraService::Client 类, 继承自 BnCamera, 并最终继承自 ICamera

CameraService::Client 类通过调用 Camera HAL 层来实现具体的功能。目前的 code 中只支持

一个 CameraService::Client 实例。

Camera Service 在 系 统 启 动 时 new 了 一 个 实 例 , 以 “ media.camera ” 为 名 字 注 册 到

ServiceManager 中。在 init.rc 中有如下代码执行可执行文件/system/bin/mediaserver,启动多

媒体服务进程。

service media /system/bin/mediaserver

Mediaserver 的 c 代码如下:

int main(int argc,char** argv)

{

sp proc(ProcessState::self());

sp sm = defaultServiceManager();

LOGI("ServiceManager: %p",sm。get());

AudioFlinger::instantiate();

MediaPlayerService::instantiate();

CameraService::instantiate();

AudioPolicyService::instantiate();

ProcessState::self()->startThreadPool();

IPCThreadState::self()->joinThreadPool();

}

Camera HAL(硬件抽象层)

Libcameraservice.so::CameraService::Client 类调用 camera HAL 的代码实现具体功能,camera

HAL 一般实现为一个动态库 libcamera.so(动态库名字可以改,只需要与 Android.mk 一致即

可)。Android 只给了一个定义文件:

/home/miracle/Work/android/android_src/froyo/frameworks/base/include/camera/CameraHard

wareInterface.h

class CameraHardwareInterface : public virtual RefBase {

public:

virtual ~CameraHardwareInterface() { }

virtual sp getPreviewHeap() const = 0;

virtual sp getRawHeap() const = 0;

virtual void setCallbacks(notify_callback notify_cb,data_callback data_cb,

data_callback_timestamp data_cb_timestamp,void* user) = 0;

virtual void enableMsgType(int32_t msgType) = 0;

virtual void disableMsgType(int32_t msgType) = 0;

virtual bool msgTypeEnabled(int32_t msgType) = 0;

virtual status_t startPreview() = 0;

virtual bool useOverlay() {return false;}

virtual status_t setOverlay(const sp &overlay) {return BAD_VALUE;}

virtual void stopPreview() = 0;官网WPS office最新的下载网站在哪里

virtual bool previewEnabled() = 0;

virtual status_t startRecording() = 0;

virtual bool recordingEnabled() = 0;

virtual status_t autoFocus() = 0;

virtual status_t cancelAutoFocus() = 0;

virtual status_t takePicture() = 0;

virtual status_t cancelPicture() = 0;

virtual status_t setParameters(const CameraParameters& params) = 0;

virtual CameraParameters getParameters() const = 0;

virtual status_t sendCommand(int32_t cmd,int32_t arg1,int32_t arg2) = 0;

virtual void release() = 0;

virtual status_t dump(int fd,const Vector & args) const = 0;

};

extern "C" sp openCameraHardware();

}; // namespace android

可以看到在 JAVA Ap 中的功能调用最终会调用到 HAL 层这里,Camera HAL 层的实现是主要

的工作, 它一般通过 V4L2 command 从 linux kernel 中的 camera driver 得到 preview 数据。然

后交给 surface(overlay)显示或者保存为文件。在 HAL 层需要打开对应的设备文件,并通过

ioctrl 访问 camera driver。Android 通过这个 HAL 层来保证底层硬件(驱动)改变,只需修改

对应的 HAL 层代码,FrameWork 层与 JAVA Ap 的都不用改变。

Preview 数据流程

Android 框架中 preview 数据的显示过程如下:

1、 打开内核设备文件。CameraHardwareInterface.h 中定义的 openCameraHardware()打开

linux kernel 中的 camera driver 的设备文件(如/dev/video0) ,创建初始化一些相关的类

的实例。

2、 设置摄像头的工作参数。CameraHardwareInterface.h 中定义的 setParameters()函数,在

这一步可以通过参数告诉 camera HAL 使用哪一个硬件摄像头, 以及它工作的参数 (size,

format 等) ,并在 HAL 层分配存储 preview 数据的 buffers(如果 buffers 是在 linux kernel

中的 camera driver 中分配的,在这一步也会拿到这些 buffers mmap 后的地址指针) 。

3、 设置显示目标。需在 JAVA APP 中创建一个 surface 然后传递到 CameraService 中。会调

用到 libcameraservice.so 中的 setPreviewDisplay(const sp & surface)函数中。在

这里分两种情况考虑:一种是不使用 overlay;一种是使用 overlay 显示。如果不使用

overlay 那设置显示目标最后就在 libcameraservice.so 中,不会进 Camera HAL 动态库。

并将上一步拿到的 preview 数据 buffers 地址注册到 surface 中。 如果使用 overlay 那在

libcameraservice.so 中会通过传进来的 Isurface 创建 Overlay 类的实例,然后调用

CameraHardwareInterface.h 中定义的 setOverlay()设置到 Camera HAL 动态库中。

4、 开始 preview 工作。最终调用到 CameraHardwareInterface.h 中定义的 startPreview()函 wps office免费版下载的方法在哪里数。

如果不使用 overlay,Camera HAL 得到 linux kernel 中的 preview 数据后回调通知到

libcameraservice.so 中。在 libcameraservice.so 中会使用上一步的 surface 进行显示。如

果使用 overlay, Camera HAL 得到 linux kernel 中的 preview 数据后直接交给 Overlay 对象,

然后有 Overlay HAL 去显示。

模拟器中的虚拟 camera

如果没有 camera 硬件,不实现真正的 Camera HAL 动态库,可以使用虚拟 camera。源代码

位于:

frameworks/base/camera/libcameraservice/FakeCamera.cpp

frameworks/base/camera/libcameraservice/CameraHardwareStub.cpp

FakeCamera.cpp 文件提供虚拟的 preview 数据。CameraHardwareStub.cpp 文件中实现了

camera HAL(硬件抽象层)的功能。当宏 USE_CAMERA_STUB 为 true 时可以使用这个虚拟的

camera。

ifeq ($(USE_CAMERA_STUB),true)

LOCAL_STATIC_LIBRARIES += libcamerastub //虚拟的 camera

#if want show LOGV message,should use follow define。 add 0929

#LOCAL_CFLAGS += -DLOG_NDEBUG=0

LOCAL_CFLAGS += -include CameraHardwareStub。h

else

LOCAL_SHARED_LIBRARIES += libcamera //真正的 camera HAL 库

endif

框架图

Overlay 简单介绍

overlay 一般用在 camera preview,视频播放等需要高帧率的地方,还有可能 UI 界面设计

的需求, 如map 地图查看软件需两层显示信息。 overlay 需要硬件与驱动的支持。 Overlay 没

有 java 层的 code,也就没有 JNI 调用。一般都在 native 中使用。

Overlay 的使用方法

1. 头文件

overlay object 对外的接口

#include

下面三个用于从 HAL 得到 overlay object

#include

#include

#include

2. 相关动态库文件

libui.so

libsurfaceflinger_client.so

3. 调用步骤

创建 surfaceflinger 的客户端

sp client = new SurfaceComposerClient();

创建推模式 surface

sp surface = client->createSurface(getpid(),0,320,240,

PIXEL_FORMAT_UNKNOWN,IsurfaceComposer::ePushBuffers);

获得 surface 接口

sp isurface = surface->getISurface();

获得 overlay 设备

sp ref = isurface->createOverlay(320,240,PIXEL_FORMAT_RGB_565);

这里会通过调用 overlay hal 层的 createoverlay()打开对应的设备文件。

创建 overlay 对象

sp overlay = new Overlay(ref);

使用 overlay API

overlay_buffer_t buffer; //typedef void* overlay_buffer_t;

void* address = overlay->getBufferAddress(buffer);

address 指针就是 mmap 后的 overlay buffer 指针, 只需将数据填充到这个 address 指针就可

以看到画面了。

Android overlay 框架

overlay 本地框架代码

源代码位于:frameworks/base/libs/ui/ ,编译到 libui.so 中。

Overlay.cpp : 提 供 给 外 部 程 序 调 用 的 Overlay object 接 口 与 API 。 定 义 在

frameworks/base/include/ui/Overlay.h 中。实现了两个类:OverlayRef 与 Overlay。外部

程序通过这个 Overlay 对象来使用 overlay 的功能。Overlay.cpp 内部通过 binder 与

surfaceFlinger service 通信,最终调用到 Overlay HAL。

IOVerlay.cpp: 定义提供 binder 所需的类, 其中 LayerBuffer::OverlaySource::OverlayChannel

继承自 BnOverlay。

overlay 的服务部分代码

源代码位于:frameworks/base/libs/surfaceflinger/

overlay 系统被包在 Surface 系统中, 通过 surface 来控制 overlay 或者在不使用 overlay 的情

况下统一的来管理。所以 overlay 的 service 部分也包含在 SurfaceFlinger service 中,主要的

类 LayerBuffer。

android 启动的时候会启动 SurfaceFlinger service,SurfaceFlinger 启动时会实例化一个

DisplayHardware:

DisplayHardware* const hw = new DisplayHardware(this,dpy);

DisplayHardware 构造函数调用函数 init:

DisplayHardware::DisplayHardware(const sp & flinger,

uint32_t dpy)

: DisplayHardwareBase(flinger,dpy)

{

init(dpy);

}

Init 函数中:

if(hw_get_module(OVERLAY_HARDWARE_MODULE_ID,&module) == 0) {

overlay_control_open(module,&mOverlayEngine);

}

获得 overlay 的 module 参数, 调用 overlay_control_open 获取控制设备结构 mOverlayEngine。

拥有了控制设备结构体就可以创建数据设备结构体 ,并具体控制使用 overlay 了。

overlay HAL 层

源代码位于:hardware/libhardware/include/hardware/overlay.h

android 只给出了接口的定义,需要我们自己实现具体的功能。 overlay hal 层生成的动态库

在 SurfaceFlinger 中显式的加载。Overlay HAL 层具体功能如何实现取决于硬件与驱动程序。

Android 提供了一个 Overlay Hal 层实现的框架代码, hardware/libhardware/modules/overlay/。

因为 overlay hal 层生成的动态库是显式的动态打开(hw_get_module -> dlopen),所以这个库

文件必须放在文件系统的 system/lib/hw/下。

多层 overlay

例如需要同时支持 overlay1 与 overlay2。

1. overlay hal 的 overlay_control_device_t 中要添加 overlay1 与 overlay2 的结构:

struct overlay_control_context_t {

struct overlay_control_device_t device;

/* our private state goes below here */

struct overlay_t* overlay_video1;//overlay1

struct overlay_t* overlay_video2;//overlay2

};

每个 overlay_t 代表一层 overlay,每层 ovelay 有自己的 handle。

在构造 OverlayRef 之前需指明使用哪一层 overlay:

sp ref = isurface->createOverlay(320,240,PIXEL_FORMAT_RGB_565);

可以使用自定义参数调用 overlay_control_device_t::setParameter()来指定 Hal 层具体实现。

2,通过 Overlay object 来拿到 overlay1 与 overlay2 的 buffer 指针。

digital_data.h 内容: